-

Daniel Andler

Daniel Andler Professeur émérite de Sorbonne Université {à l’époque Paris IV} (philosophie des sciences et théorie de la connaissance), membre honoraire de l’Institut universitaire de France, membre de l’Académie des sciences morales et politiques.

Source : https://andler.ens.psl.eu/biographie/

-

L’intelligence générale artificielle : mirage ou faux raccord ?

-

OpenRouter

OpenRouter OpenRouter est un service API qui agrège l'accès à plus de 500 modèles de langage provenant d'une soixantaine de fournisseurs via une interface centralisé. La plateforme implémente un système de routage avec basculement automatique (fallback) entre fournisseurs en cas d'indisponibilité, permettant d'interroger différents modèles (GPT-4, Claude, Llama, Gemini, etc.) sans gérer plusieurs intégrations. Elle prend en charge les politiques de données configurables et le mode BYOK (Bring Your Own Key) pour utiliser ses propres clés API des fournisseurs. La facturation est proportionnel à l'utilisation (tokens) et aucun abondement est requis.

-

Capture d'écran d'OpenRouter

Capture d'écran d'OpenRouter

-

Logo d'OpenRouter

Logo d'OpenRouter

-

Logo de DeepSeek R1

Logo de DeepSeek R1

-

DeepSeek-R1

DeepSeek-R1 DeepSeek-R1 est un modèle de langage spécialisé dans le raisonnement logique, développé via l'apprentissage par renforcement (RL) à grande échelle. Il excelle dans la résolution de problèmes complexes en mathématiques, en programmation et en raisonnement analytique, avec des performances comparables à OpenAI-o1. Le modèle utilise une architecture Mixture of Experts (MoE) avec 671 milliards de paramètres totaux, dont 37 milliards activés par requête, permettant une efficacité optimale.

-

image pour Ajout de nos mots-clés EdiSem dans la base vectoriel

image pour Ajout de nos mots-clés EdiSem dans la base vectoriel

-

Ajout de nos mots-clés EdiSem dans la base vectorielle

Ajout de nos mots-clés EdiSem dans la base vectorielle Ce workflow n8n ingère le contenu de fichiers (PDF/CSV) et les indexe dans la base vectorielle de Supabase Vector Store afin que l’agent IA puisse associer et reconnaître nos mots-clés exacts lors de sa tâche. Il est conçu pour être réutilisable à tout moment pour ajouter de nouveaux mots-clés et mettre à jour la base vectorielle, garantissant que le RAG soit à jour.

-

Capture d'écran du prototype de workflow pour le traitement de conférence

Capture d'écran du prototype de workflow pour le traitement de conférence

-

Prototype de transcription et de génération de résumé par IA de vidéo

Prototype de transcription et de génération de résumé par IA de vidéo Prototype local orchestré dans n8n qui prend une URL YouTube, extrait l’audio avec yt-dlp, transcrit en SRT via Whisper en local, puis génère uniquement un résumé en français avec DeepSeek via l’API OpenRouter; sortie sauvegardée en texte nommé d’après le titre de la vidéo.

-

image pour Génération Open Source d'une image d'un bébé prématuré 1

image pour Génération Open Source d'une image d'un bébé prématuré 1

-

Capture d'écran de l'interface de ComfyUI 1

Capture d'écran de l'interface de ComfyUI 1

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 6

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 6

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 5

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 5

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 4

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 4

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 3

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 3

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 2

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 2

-

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 1

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 1

-

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 3

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 3

-

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 2

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 2

-

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA

-

Capture d'écran de l'interface de diffusion_pipe_new_ui

Capture d'écran de l'interface de diffusion_pipe_new_ui

-

Capture d'écran de l'interface graphique de Blender

Capture d'écran de l'interface graphique de Blender

-

Image pour Réalisation d'un court métrage à partir de clips générés par IA

Image pour Réalisation d'un court métrage à partir de clips générés par IA

-

Capture d'écran du workflow n8n 2

Capture d'écran du workflow n8n 2

-

Quelques limites des LLMs en production n8n

Quelques limites des LLMs en production n8n Les résumés chronologiques initiaux se sont révélés trop génériques pour un usage opérationnel, tandis que l’extraction de citations par le LLM se biaisait vers le début de la conférence en l’absence de contrainte de distribution temporelle. Des prompts devenus trop volumineux ont accru les risques de troncature et de perte de contexte sur de longs SRT, aggravés par les plafonds de tokens des nœuds dans n8n. De plus, peu de modèles utilisent de façon stable la fonction d'appel d'outil dans n8n, compliquant l’appel au RAG lors de l’association de mots‑clés, ce qui impose d’optimiser la charge contextuelle selon la taille du SRT. L'ajustement des division en segments avec léger recouvrement, des prompts précis et détaillé adapté à chaque tâche on été tentés . Résultats, une meilleure couverture des contenus et le fil argumentatif est mieux respecté, les micro résumés sont plus précis et les mots‑clés sont plus discriminants après les itérations de prompts et une segmentation adaptée. Dans le cas du RAG, la tokenisation peut fragmenter les formes avec traits d’unions, conduisant à des termes tronqués. Par exemple, “Post‑vérité” sera réduit à “vérité”. Ce qui peu être mitiger par une normalisation, l'ajout de formes composées dans la base vectoriel ou encore par un simple nœud de code Javascript en post‑traitement.

-

Capture d'écran d'un segment du workflow n8n 1

Capture d'écran d'un segment du workflow n8n 1

-

La qualité de la transcription est primordiale : de Whisper local à l’API d'OpenAI

La qualité de la transcription est primordiale : de Whisper local à l’API d'OpenAI Au départ, une exécution locale de Whisper‑medium donnait une qualité insuffisante sur des conférences en français avec accents; le passage à l’API OpenAI whisper‑1 a significativement amélioré la qualité globale.

Le workflow a été adapté pour découper l’audio en tranches de 15 minutes afin de respecter les contraintes d’entrée, puis agréger et réaligner les SRT en fin de chaîne.

Sur des vidéos de plus d’une heure, une dégradation reste toute de même présente dû aux limitations de n8n sur la longueur maximale des contextes allouer au LLM.

-

Capture d'écran de la cinquième itération du workflow n8n de traitement automatique de vidéo

Capture d'écran de la cinquième itération du workflow n8n de traitement automatique de vidéo

-

Capture d'écran de l'interface en ligne de commande de yt-dlp

Capture d'écran de l'interface en ligne de commande de yt-dlp

-

Logo de yt-dlp

Logo de yt-dlp

-

Logo de Docker

Logo de Docker

-

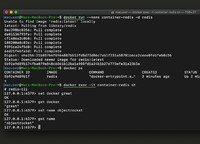

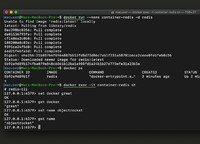

Capture d'écran d'une utilisation en ligne de commande de Docker

Capture d'écran d'une utilisation en ligne de commande de Docker

-

Capture d'écran de l'interface graphique de Docker

Capture d'écran de l'interface graphique de Docker

-

Logo de Supabase Vector Store

Logo de Supabase Vector Store

-

Capture d'écran de l'interface de Supabase Vector Store

Capture d'écran de l'interface de Supabase Vector Store

-

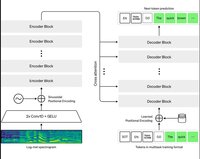

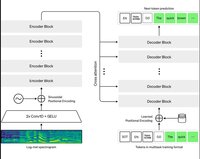

Schéma de l'architecture du modèle Whisper d'OpenAI

Schéma de l'architecture du modèle Whisper d'OpenAI

-

Image de Whisper d'OpenAI

Image de Whisper d'OpenAI

-

À partir du moment où vous pensez que vous travaillez pour le bien, la notion éthique est rapidement évacuée, elle devient comme immanente.

-

L'objectif, dans le fond, c'est de comparer ce qu'un promoteur sait, son bagage de connaissances, comparer ça avec ce qu'il fait dans la réalité et comparer ça avec ce qu'il dit de ce qu'il sait et ce qu'il dit de ce qu'il fait.

-

Pour Goss Field, le problème social est indissociable des acteurs sociaux qu'il porte à l'attention du public. Un problème social, en sociologie, ça n'existe pas tant qu'il n'est pas reconnu par le public.

-

Études de cas et implications

Cas du Club des petits-déjeuners et de Recyc-Québec: évolution d’hypothèses sans validation empirique robuste, redéfinition d’objectifs sans cadre légal formel. Illustration des effets concrets de la dramaturgie sur la perception d’efficacité, la définition des cibles et la trajectoire publique des causes.

-

Fictionnalisation, dramatisation et contrôle social

Étude de la factualisation fictive: sélection/torsion des données pour persuader et engager, effets sur l’efficacité de l’action publique. La dramatisation amplifie les faits, met en scène les choix moraux sur la place publique, et mobilise via sélectivité dramatique et inflation verbale.

-

Axiomes, méthode et mise en scène

Exposé des axiomes de Gossefield: normes et déviances construites par les acteurs sociaux. Méthodologie dramaturgique centrée sur la cohérence interne des discours, principe de charité pour limiter les biais, et analyse des procédés de mise en scène/fiction pour structurer les problèmes et capter l’attention.

-

Origines et écoles de Chicago

Ancrage de l’analyse dramaturgique dans les trois écoles de Chicago, influencées par les arts et la littérature. Mise en avant de l’interactionnisme et de l’observation participante, ainsi que de leur impact durable sur la sociologie, notamment au Québec.

-

Cadre et processus des problèmes sociaux

Présentation du cadre théorique: définition et légitimation des problèmes sociaux, rôle des promoteurs et entrepreneurs de causes, sélectivité des faits et narration pour mobiliser. Description du passage du problème social au problème public (prise en charge par l’État), de l’agenda setting et de la carrière d’une cause (émergence, gains, investissements, extinction/gestion).

-

Toute la question de l’intelligence artificielle, à travers Fabien et moi‑même, est absolument intéressante pour notre groupe, parce que c’est vraiment la technologie par excellence contemporaine qui permet justement de faire des mécanismes de tromperie comme on en a rarement vu.

-

Vous savez donc, pour beaucoup d’entre vous, que ce séminaire en est à sa troisième édition, et on poursuit toujours cette thématique qui porte sur les stratégies de l’illusion, sur la tromperie, sur le mensonge, en connectant des domaines qui généralement ne se relient pas ensemble, dont celui des arts trompeurs.

-

Annonces finales et clôture

Annonce d’Aurélie: appel d’articles pour un numéro de revue Quaderni sur ce que les médias font aux controverses (axes: personnalisation algorithmique, économie de l’attention, controversification), puis remerciements finaux, rappel du caractère interuniversitaire, et du dispositif éditorial pour mutualiser les recherches; rendez‑vous à la prochaine séance.

-

Participation étudiante et sujets

Invitation aux étudiants à proposer de courts exposés pour la séance du 9 décembre; suggestions de thèmes (théâtre invisible, design/arts trompeurs) et coordination via Gabrielle pour l’organisation.

-

Transhumanisme, IA et controverses

Aperçu d’interventions sur la rhétorique transhumaniste (travaux de Maud Bonenfant avec Emmanuel Kakamo), échos à un ouvrage récent sur machine learning, et point sur les séances de décembre (controverses, arts trompeurs, croisements Jean‑Marc/Sylvie; possibles ajustements domino).

-

Stratégie du faux et nostalgie

Annonce d’une présentation de Katharina Nehmeyer sur Stratégie du faux et nostalgie réactionnaire autour de la vidéo de campagne d’Éric Zemmour, avec retour sur le concept de nationalisme nostalgique et ses marqueurs médiatique

-

Programme automnal et invités

Présentation détaillée du calendrier à venir: séance du 20 septembre sur automates et illusions, puis 7 octobre sur la désinformation avec Marcello Vitali Rossetti et Nicolas Sorey; mention de sujets en écriture numérique à l’UdeM et d’intervenants internationaux, avec alternance arts trompeurs/écosystème socio-numérique tout l’automne

-

Guillaume et Victoire : Intérêts divers

Guillaume, ancien étudiant en humanité numérique, et Victoire, étudiante à la Sorbonne, expriment leur intérêt pour les écosystèmes socio-numériques et les arts trompeurs.

-

Emmanuelle Carpon : Voix et guerre

Emmanuelle, étudiant en cinéma, travaille sur l'installation audio-visuelle et les voix de la guerre, en particulier dans le contexte du conflit en Ukraine.

-

Mathieu Lemoyne : Théâtre invisible

Mathieu, étudiant en littérature, explore le théâtre invisible d'Augusto Boal et ses frontières avec la fiction, et s'initie à la recherche à travers le séminaire.

-

Maxime Pigeon : Design et opacité

Maxime, étudiant en design graphique, s'intéresse à la réflexion dans la pratique du graphisme et à la notion d'opacité et de relation selon Édouard Glissant.

-

Rémi Besson : Histoire et cinéma

Rémi explore les rapports entre histoire, cinéma et technique, et collecte des effets visuels et trompeurs pour le dispositif éditorial, en s'appuyant sur une approche intermédiale.

-

Gabrielle Godin : Médiation culturelle

Gabrielle s'intéresse aux médiateurs dans les arts vivants et développe un modèle d'éditorialisation avec Oméka-S pour organiser des textes et concepts de recherche.

-

Orélie Desfriches Doriat : Controverses

Orélie travaille sur l'analyse des controverses, la modélisation des arguments, et la formation de l'esprit critique chez les étudiants. Elle dirige aussi le développement d'un outil d'analyse textuelle.

-

Dispositif éditorial

Discussion sur le développement d'un dispositif numérique de web sémantique pour mutualiser les recherches et analyser les cas d'illusions et de tromperies dans divers domaines.

-

Jérémie Pelletier-Gagnon : Jeu vidéo

Jérémie, à l'Université de l'Ontario français, se concentre sur le jeu vidéo japonais et l'arcade, et explore la communication artificielle avec les personnages interactifs.

-

Sylvie Lelumerviel : Info-llusions

Sylvie, professeure en sciences de l'information, s'intéresse aux artefacts médiatiques et à la construction du sens. Elle travaille sur les fake news et les personnages construits dans les médias.

-

Fabien Richert : Tromperie et simulation

Fabien, professeur à l'UQAM, explore les rapports entre objets techniques et monde social, avec un intérêt pour le simulacre et l'hyperréalité. Il étudie les jeux en réalité alternée et l'esthétisation des œuvres de fiction.

-

Jean-Marc Larue : Arts trompeurs

Jean-Marc, professeur de théâtre, discute de l'intermédialité et de l'histoire des arts trompeurs. Il s'intéresse aux nouveaux matérialismes et à la question du consentement dans la tromperie.

-

Présentation des participants

Présentation des membres du groupe de recherche, de leurs affiliations universitaires et de leurs intérêts de recherche, incluant des domaines comme le design et l'écosystème sociolumérique.

-

Introduction au séminaire

Renée introduit ce séminaire qui explore les stratégies d'illusion et de tromperie en connectant les arts trompeurs et les écosystèmes numériques.Le séminaire aborde des domaines variés, tels que le cinéma, les jeux vidéo, les arts vivants et la muséologie, et examine les régimes d'autorité et de légitimité à l'ère numérique.

-

Réception et conséquences des deepfakes

La réception des deepfakes suscite de fortes émotions et inquiète quant à la perception du vrai. Leur impact sur l'identité et la crédibilité des vidéos est discuté, ainsi que leurs implications juridiques, comme dans l'affaire Dieudonné. La conférence conclut en soulignant la nécessité de discuter des mobilisations contre les deepfakes et leur réception.

-

Analyse philosophique des deepfake

Les deepfakes sont analysés sous un angle philosophique, questionnant la vérité et la réalité des images numériques. La capacité des images à représenter le vrai est remise en cause, et les deepfakes simulent plutôt qu'ils ne reproduisent la réalité. La pensée de Jean Baudrillard sur le simulacre est évoquée pour comprendre ces enjeux.

-

Exemples et implications des deepfakes

Des exemples récents de deepfakes incluent des vidéos de Mark Zuckerberg et Tom Cruise, illustrant divers objectifs comme l'éducation et la satire. Les deepfakes sont classés selon leur sophistication technique, de deepfakes à cheapfakes. Ces manipulations simples, comme le ralentissement de la vidéo de Nancy Pelosi, montrent l'impact des contenus manipulés.

-

Deepfakes dans le contexte médiatique

Philippe discute des deepfakes comme phénomène de désinformation, soulignant leur spécificité par rapport à d'autres images manipulées. Il aborde les contextes discursifs et médiatiques, les intentions de production et les modes de réception. Les deepfakes sont souvent accompagnés de messages éducatifs ou d'alertes sur leur potentiel trompeur.

-

Origines et évolution des deepfakes

La discussion se poursuit sur l'origine du terme deepfake, contraction de deep learning et fake, et son apparition en 2017 sur Reddit. Les premières applications datent de 2015. Des exemples notables incluent un discours truqué d'Obama, illustrant le potentiel éducatif des deepfakes, et l'infocalypse, une menace amplifiée par les plateformes numériques.

-

Exemple de deepfake avec Macron

Angélina présente un deepfake impliquant le président Macron, réalisé par le collectif On est prêt. La vidéo, bien que techniquement imparfaite, simule l'apparence et les gestes de Macron pour délivrer un discours écologique honnête. Le décalage entre le visuel faux et le discours vrai suscite réflexion, et la vidéo ne cache pas son statut de deepfake.

-

Introduction et cadre du séminaire

La conférence débute par une introduction sur les enjeux temporels et la présentation des intervenants, notamment Angélina, récemment devenue docteure. Le séminaire explore les deepfakes et leur impact sur les régimes d'authenticité dans une ère de post-vérité, en examinant les transformations des systèmes de vérité et de légitimité dans les médias contemporains.

-

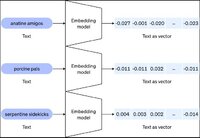

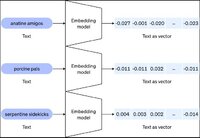

OpenAI Embeddings

OpenAI Embeddings OpenAI Embeddings est un service qui convertit du texte en représentations numériques vectorielles (embeddings) permettant de mesurer la similarité sémantique entre différents textes. Ces vecteurs capturent le sens et le contexte du texte, permettant des applications comme la recherche sémantique, les systèmes de recommandation, la classification de texte, le clustering de documents et la détection d'anomalies. Les embeddings sont essentiels pour les architectures RAG (Retrieval Augmented Generation) où ils permettent de retrouver des informations pertinentes dans de grandes bases de données.

-

GPT-4o

GPT-4o GPT-4o ("o" pour "omni") est un modèle de langage multimodal génératif développé par OpenAI, capable de traiter et de générer du texte, des images et de l'audio. Il représente une avancée majeure avec des capacités de raisonnement améliorées, un traitement multilingue dans plus de 50 langues, une compréhension contextuelle sophistiquée, et une analyse de sentiment à travers différentes modalités. Le modèle offre des interactions en temps réel avec des réponses quasi instantanées et peut effectuer des traductions simultanées, analyser des données visuelles, et comprendre des contenus audio.

-

OpenAI Whisper

OpenAI Whisper Le modèle Whisper est un système de reconnaissance vocale polyvalent. Il a été entraîné sur un vaste ensemble de données audio variées et il s’agit également d’un modèle multitâche capable d’effectuer la reconnaissance vocale multilingue, la traduction de la parole et l’identification des langues.

-

Supabase Vector Store

Supabase Vector Store Supabase Vector Store est une fonctionnalité permettant de stocker et d'interroger des vecteurs d'embeddings dans une base de données PostgreSQL via l'extension pgvector. Cette solution permet de réaliser des recherches par similarité vectorielle, particulièrement utile pour les applications d'intelligence artificielle utilisant des grands modèles de langage (LLM) et le Retrieval Augmented Generation (RAG).

-

Docker

Docker Docker est une plateforme permettant d'empaqueter et d'exécuter des applications dans des environnements isolés appelés conteneurs. Les conteneurs incluent tout le nécessaire pour faire fonctionner une application : code, environnement d'exécution, bibliothèques et dépendances, garantissant ainsi que l'application fonctionne de manière cohérente sur n'importe quel système.

-

yt-dlp

yt-dlp yt-dlp est un téléchargeur audio/vidéo en ligne de commande riche en fonctionnalités qui prend en charge des milliers de sites web. Il s'agit d'un fork du projet youtube-dl, basé sur le désormais inactif youtube-dlc

-

Automatisation du traitement de résumés de conférences académiques par un workflow n8n

Automatisation du traitement de résumés de conférences académiques par un workflow n8n Développer une chaîne de traitement automatisée permettant de transcrire le contenue, généré des résumées, d'extraire des citations ainsi que d'associé des mots-clés de vidéo de conférence académique pour faciliter leur indexation, leur valorisation documentaire et leur intégration dans Omeka S. L'objectif est d'accélérer le processus tout en maintenant une validation humaine finale pour garantir la qualité académique.

-

Le deepfake, en tant que vidéo truquée, peut donc se penser en philosophie, en regard de la triade conceptuelle qui a déjà été annoncée par Philippe, l'image, vérité, réalité. parce qu'on attend d'une vidéo présenté comme non-fictionnel qu'elle nous dévoile une dimension du réel [...].

-

Les deepfakes, comme d'autres images cinématographiques, sont souvent un mixage entre le monde réel et non réel : un imaginaire.

-

Les deepfakes appartiennent à la série culturelle des images documentaires, non pas au sens du genre documentaire, du genre filmique documentaire, mais au sens où elles renvoient à des empreintes directes de la réalité.

-

Les deepfakes participent finalement à ce phénomène général de désinformation et on franchit un palier supplémentaire.

-

Le terme deepfake, ça vient de la contraction entre deep learning, qui est la technologie qui a impulsé les méthodes de manipulation de l'image au moyen de l'intelligence artificielle, et de fake, le faux. Le terme désigne ce qu'on nomme aussi en français cette fois ; hyper trucage.

-

Les deepfakes sont des manipulations numériques de contenus audio et vidéo hautement réalistes et difficiles à détecter.

-

Les deepfakes nous intéressent ici dans la mesure où ils perturbent le régime d'authenticité de l'image, sa référentialité.

-

Les arcanes du vrai à l’heure des deep fakes : authenticité et dispositifs de véridiction

-

Hoyte van Hoytema

Hoyte van Hoytema

-

Captures d'écran du film Her (2013)

Captures d'écran du film Her (2013)

-

The Fall of the Aztec Empire (1521) Image 3

The Fall of the Aztec Empire (1521) Image 3

-

The Fall of the Aztec Empire (1521) Image 2

The Fall of the Aztec Empire (1521) Image 2

-

The Fall of the Aztec Empire (1521) Image 1

The Fall of the Aztec Empire (1521) Image 1

-

Vladan Joler

Vladan Joler

-

JavaScript

JavaScript « JavaScript (JS) est un langage de programmation léger, interprété (ou compilé juste‑à‑temps), avec des fonctions de première classe; il est surtout connu comme langage de script des pages Web, mais est aussi utilisé hors navigateur, par exemple avec Node.js, Apache CouchDB ou Adobe Acrobat. »

-Traduit par GPT-5

Source : https://developer.mozilla.org/en-US/docs/Web/JavaScript

-

Jack Halberstam

Jack Halberstam

-

Terence Broad

Terence Broad

-

Anil Bawa-Cavia

Anil Bawa-Cavia

Daniel Andler Professeur émérite de Sorbonne Université {à l’époque Paris IV} (philosophie des sciences et théorie de la connaissance), membre honoraire de l’Institut universitaire de France, membre de l’Académie des sciences morales et politiques. Source : https://andler.ens.psl.eu/biographie/

Daniel Andler Professeur émérite de Sorbonne Université {à l’époque Paris IV} (philosophie des sciences et théorie de la connaissance), membre honoraire de l’Institut universitaire de France, membre de l’Académie des sciences morales et politiques. Source : https://andler.ens.psl.eu/biographie/ OpenRouter OpenRouter est un service API qui agrège l'accès à plus de 500 modèles de langage provenant d'une soixantaine de fournisseurs via une interface centralisé. La plateforme implémente un système de routage avec basculement automatique (fallback) entre fournisseurs en cas d'indisponibilité, permettant d'interroger différents modèles (GPT-4, Claude, Llama, Gemini, etc.) sans gérer plusieurs intégrations. Elle prend en charge les politiques de données configurables et le mode BYOK (Bring Your Own Key) pour utiliser ses propres clés API des fournisseurs. La facturation est proportionnel à l'utilisation (tokens) et aucun abondement est requis.

OpenRouter OpenRouter est un service API qui agrège l'accès à plus de 500 modèles de langage provenant d'une soixantaine de fournisseurs via une interface centralisé. La plateforme implémente un système de routage avec basculement automatique (fallback) entre fournisseurs en cas d'indisponibilité, permettant d'interroger différents modèles (GPT-4, Claude, Llama, Gemini, etc.) sans gérer plusieurs intégrations. Elle prend en charge les politiques de données configurables et le mode BYOK (Bring Your Own Key) pour utiliser ses propres clés API des fournisseurs. La facturation est proportionnel à l'utilisation (tokens) et aucun abondement est requis. Capture d'écran d'OpenRouter

Capture d'écran d'OpenRouter  Logo d'OpenRouter

Logo d'OpenRouter  Logo de DeepSeek R1

Logo de DeepSeek R1  DeepSeek-R1 DeepSeek-R1 est un modèle de langage spécialisé dans le raisonnement logique, développé via l'apprentissage par renforcement (RL) à grande échelle. Il excelle dans la résolution de problèmes complexes en mathématiques, en programmation et en raisonnement analytique, avec des performances comparables à OpenAI-o1. Le modèle utilise une architecture Mixture of Experts (MoE) avec 671 milliards de paramètres totaux, dont 37 milliards activés par requête, permettant une efficacité optimale.

DeepSeek-R1 DeepSeek-R1 est un modèle de langage spécialisé dans le raisonnement logique, développé via l'apprentissage par renforcement (RL) à grande échelle. Il excelle dans la résolution de problèmes complexes en mathématiques, en programmation et en raisonnement analytique, avec des performances comparables à OpenAI-o1. Le modèle utilise une architecture Mixture of Experts (MoE) avec 671 milliards de paramètres totaux, dont 37 milliards activés par requête, permettant une efficacité optimale. image pour Ajout de nos mots-clés EdiSem dans la base vectoriel

image pour Ajout de nos mots-clés EdiSem dans la base vectoriel  Ajout de nos mots-clés EdiSem dans la base vectorielle Ce workflow n8n ingère le contenu de fichiers (PDF/CSV) et les indexe dans la base vectorielle de Supabase Vector Store afin que l’agent IA puisse associer et reconnaître nos mots-clés exacts lors de sa tâche. Il est conçu pour être réutilisable à tout moment pour ajouter de nouveaux mots-clés et mettre à jour la base vectorielle, garantissant que le RAG soit à jour.

Ajout de nos mots-clés EdiSem dans la base vectorielle Ce workflow n8n ingère le contenu de fichiers (PDF/CSV) et les indexe dans la base vectorielle de Supabase Vector Store afin que l’agent IA puisse associer et reconnaître nos mots-clés exacts lors de sa tâche. Il est conçu pour être réutilisable à tout moment pour ajouter de nouveaux mots-clés et mettre à jour la base vectorielle, garantissant que le RAG soit à jour. Capture d'écran du prototype de workflow pour le traitement de conférence

Capture d'écran du prototype de workflow pour le traitement de conférence  Prototype de transcription et de génération de résumé par IA de vidéo Prototype local orchestré dans n8n qui prend une URL YouTube, extrait l’audio avec yt-dlp, transcrit en SRT via Whisper en local, puis génère uniquement un résumé en français avec DeepSeek via l’API OpenRouter; sortie sauvegardée en texte nommé d’après le titre de la vidéo.

Prototype de transcription et de génération de résumé par IA de vidéo Prototype local orchestré dans n8n qui prend une URL YouTube, extrait l’audio avec yt-dlp, transcrit en SRT via Whisper en local, puis génère uniquement un résumé en français avec DeepSeek via l’API OpenRouter; sortie sauvegardée en texte nommé d’après le titre de la vidéo. image pour Génération Open Source d'une image d'un bébé prématuré 1

image pour Génération Open Source d'une image d'un bébé prématuré 1  Capture d'écran de l'interface de ComfyUI 1

Capture d'écran de l'interface de ComfyUI 1  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 6

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 6  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 5

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 5  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 4

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 4  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 3

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 3  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 2

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 2  image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 1

image pour Entrainement de LoRA (Low Rank Adaptation model) avec diffusion_pipe 1  image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 3

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 3  image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 2

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA 2  image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA

image pour MadBeat – Court métrage réalisé à partir de vidéos générés par IA  Capture d'écran de l'interface de diffusion_pipe_new_ui

Capture d'écran de l'interface de diffusion_pipe_new_ui  Capture d'écran de l'interface graphique de Blender

Capture d'écran de l'interface graphique de Blender  Image pour Réalisation d'un court métrage à partir de clips générés par IA

Image pour Réalisation d'un court métrage à partir de clips générés par IA  Capture d'écran du workflow n8n 2

Capture d'écran du workflow n8n 2  Quelques limites des LLMs en production n8n Les résumés chronologiques initiaux se sont révélés trop génériques pour un usage opérationnel, tandis que l’extraction de citations par le LLM se biaisait vers le début de la conférence en l’absence de contrainte de distribution temporelle. Des prompts devenus trop volumineux ont accru les risques de troncature et de perte de contexte sur de longs SRT, aggravés par les plafonds de tokens des nœuds dans n8n. De plus, peu de modèles utilisent de façon stable la fonction d'appel d'outil dans n8n, compliquant l’appel au RAG lors de l’association de mots‑clés, ce qui impose d’optimiser la charge contextuelle selon la taille du SRT. L'ajustement des division en segments avec léger recouvrement, des prompts précis et détaillé adapté à chaque tâche on été tentés . Résultats, une meilleure couverture des contenus et le fil argumentatif est mieux respecté, les micro résumés sont plus précis et les mots‑clés sont plus discriminants après les itérations de prompts et une segmentation adaptée. Dans le cas du RAG, la tokenisation peut fragmenter les formes avec traits d’unions, conduisant à des termes tronqués. Par exemple, “Post‑vérité” sera réduit à “vérité”. Ce qui peu être mitiger par une normalisation, l'ajout de formes composées dans la base vectoriel ou encore par un simple nœud de code Javascript en post‑traitement.

Quelques limites des LLMs en production n8n Les résumés chronologiques initiaux se sont révélés trop génériques pour un usage opérationnel, tandis que l’extraction de citations par le LLM se biaisait vers le début de la conférence en l’absence de contrainte de distribution temporelle. Des prompts devenus trop volumineux ont accru les risques de troncature et de perte de contexte sur de longs SRT, aggravés par les plafonds de tokens des nœuds dans n8n. De plus, peu de modèles utilisent de façon stable la fonction d'appel d'outil dans n8n, compliquant l’appel au RAG lors de l’association de mots‑clés, ce qui impose d’optimiser la charge contextuelle selon la taille du SRT. L'ajustement des division en segments avec léger recouvrement, des prompts précis et détaillé adapté à chaque tâche on été tentés . Résultats, une meilleure couverture des contenus et le fil argumentatif est mieux respecté, les micro résumés sont plus précis et les mots‑clés sont plus discriminants après les itérations de prompts et une segmentation adaptée. Dans le cas du RAG, la tokenisation peut fragmenter les formes avec traits d’unions, conduisant à des termes tronqués. Par exemple, “Post‑vérité” sera réduit à “vérité”. Ce qui peu être mitiger par une normalisation, l'ajout de formes composées dans la base vectoriel ou encore par un simple nœud de code Javascript en post‑traitement. Capture d'écran d'un segment du workflow n8n 1

Capture d'écran d'un segment du workflow n8n 1  La qualité de la transcription est primordiale : de Whisper local à l’API d'OpenAI Au départ, une exécution locale de Whisper‑medium donnait une qualité insuffisante sur des conférences en français avec accents; le passage à l’API OpenAI whisper‑1 a significativement amélioré la qualité globale. Le workflow a été adapté pour découper l’audio en tranches de 15 minutes afin de respecter les contraintes d’entrée, puis agréger et réaligner les SRT en fin de chaîne. Sur des vidéos de plus d’une heure, une dégradation reste toute de même présente dû aux limitations de n8n sur la longueur maximale des contextes allouer au LLM.

La qualité de la transcription est primordiale : de Whisper local à l’API d'OpenAI Au départ, une exécution locale de Whisper‑medium donnait une qualité insuffisante sur des conférences en français avec accents; le passage à l’API OpenAI whisper‑1 a significativement amélioré la qualité globale. Le workflow a été adapté pour découper l’audio en tranches de 15 minutes afin de respecter les contraintes d’entrée, puis agréger et réaligner les SRT en fin de chaîne. Sur des vidéos de plus d’une heure, une dégradation reste toute de même présente dû aux limitations de n8n sur la longueur maximale des contextes allouer au LLM. Capture d'écran de la cinquième itération du workflow n8n de traitement automatique de vidéo

Capture d'écran de la cinquième itération du workflow n8n de traitement automatique de vidéo  Capture d'écran de l'interface en ligne de commande de yt-dlp

Capture d'écran de l'interface en ligne de commande de yt-dlp  Logo de yt-dlp

Logo de yt-dlp  Logo de Docker

Logo de Docker  Capture d'écran d'une utilisation en ligne de commande de Docker

Capture d'écran d'une utilisation en ligne de commande de Docker  Capture d'écran de l'interface graphique de Docker

Capture d'écran de l'interface graphique de Docker  Logo de Supabase Vector Store

Logo de Supabase Vector Store  Capture d'écran de l'interface de Supabase Vector Store

Capture d'écran de l'interface de Supabase Vector Store  Schéma de l'architecture du modèle Whisper d'OpenAI

Schéma de l'architecture du modèle Whisper d'OpenAI  Image de Whisper d'OpenAI

Image de Whisper d'OpenAI  OpenAI Embeddings OpenAI Embeddings est un service qui convertit du texte en représentations numériques vectorielles (embeddings) permettant de mesurer la similarité sémantique entre différents textes. Ces vecteurs capturent le sens et le contexte du texte, permettant des applications comme la recherche sémantique, les systèmes de recommandation, la classification de texte, le clustering de documents et la détection d'anomalies. Les embeddings sont essentiels pour les architectures RAG (Retrieval Augmented Generation) où ils permettent de retrouver des informations pertinentes dans de grandes bases de données.

OpenAI Embeddings OpenAI Embeddings est un service qui convertit du texte en représentations numériques vectorielles (embeddings) permettant de mesurer la similarité sémantique entre différents textes. Ces vecteurs capturent le sens et le contexte du texte, permettant des applications comme la recherche sémantique, les systèmes de recommandation, la classification de texte, le clustering de documents et la détection d'anomalies. Les embeddings sont essentiels pour les architectures RAG (Retrieval Augmented Generation) où ils permettent de retrouver des informations pertinentes dans de grandes bases de données. GPT-4o GPT-4o ("o" pour "omni") est un modèle de langage multimodal génératif développé par OpenAI, capable de traiter et de générer du texte, des images et de l'audio. Il représente une avancée majeure avec des capacités de raisonnement améliorées, un traitement multilingue dans plus de 50 langues, une compréhension contextuelle sophistiquée, et une analyse de sentiment à travers différentes modalités. Le modèle offre des interactions en temps réel avec des réponses quasi instantanées et peut effectuer des traductions simultanées, analyser des données visuelles, et comprendre des contenus audio.

GPT-4o GPT-4o ("o" pour "omni") est un modèle de langage multimodal génératif développé par OpenAI, capable de traiter et de générer du texte, des images et de l'audio. Il représente une avancée majeure avec des capacités de raisonnement améliorées, un traitement multilingue dans plus de 50 langues, une compréhension contextuelle sophistiquée, et une analyse de sentiment à travers différentes modalités. Le modèle offre des interactions en temps réel avec des réponses quasi instantanées et peut effectuer des traductions simultanées, analyser des données visuelles, et comprendre des contenus audio. OpenAI Whisper Le modèle Whisper est un système de reconnaissance vocale polyvalent. Il a été entraîné sur un vaste ensemble de données audio variées et il s’agit également d’un modèle multitâche capable d’effectuer la reconnaissance vocale multilingue, la traduction de la parole et l’identification des langues.

OpenAI Whisper Le modèle Whisper est un système de reconnaissance vocale polyvalent. Il a été entraîné sur un vaste ensemble de données audio variées et il s’agit également d’un modèle multitâche capable d’effectuer la reconnaissance vocale multilingue, la traduction de la parole et l’identification des langues. Supabase Vector Store Supabase Vector Store est une fonctionnalité permettant de stocker et d'interroger des vecteurs d'embeddings dans une base de données PostgreSQL via l'extension pgvector. Cette solution permet de réaliser des recherches par similarité vectorielle, particulièrement utile pour les applications d'intelligence artificielle utilisant des grands modèles de langage (LLM) et le Retrieval Augmented Generation (RAG).

Supabase Vector Store Supabase Vector Store est une fonctionnalité permettant de stocker et d'interroger des vecteurs d'embeddings dans une base de données PostgreSQL via l'extension pgvector. Cette solution permet de réaliser des recherches par similarité vectorielle, particulièrement utile pour les applications d'intelligence artificielle utilisant des grands modèles de langage (LLM) et le Retrieval Augmented Generation (RAG). Docker Docker est une plateforme permettant d'empaqueter et d'exécuter des applications dans des environnements isolés appelés conteneurs. Les conteneurs incluent tout le nécessaire pour faire fonctionner une application : code, environnement d'exécution, bibliothèques et dépendances, garantissant ainsi que l'application fonctionne de manière cohérente sur n'importe quel système.

Docker Docker est une plateforme permettant d'empaqueter et d'exécuter des applications dans des environnements isolés appelés conteneurs. Les conteneurs incluent tout le nécessaire pour faire fonctionner une application : code, environnement d'exécution, bibliothèques et dépendances, garantissant ainsi que l'application fonctionne de manière cohérente sur n'importe quel système. yt-dlp yt-dlp est un téléchargeur audio/vidéo en ligne de commande riche en fonctionnalités qui prend en charge des milliers de sites web. Il s'agit d'un fork du projet youtube-dl, basé sur le désormais inactif youtube-dlc

yt-dlp yt-dlp est un téléchargeur audio/vidéo en ligne de commande riche en fonctionnalités qui prend en charge des milliers de sites web. Il s'agit d'un fork du projet youtube-dl, basé sur le désormais inactif youtube-dlc Automatisation du traitement de résumés de conférences académiques par un workflow n8n Développer une chaîne de traitement automatisée permettant de transcrire le contenue, généré des résumées, d'extraire des citations ainsi que d'associé des mots-clés de vidéo de conférence académique pour faciliter leur indexation, leur valorisation documentaire et leur intégration dans Omeka S. L'objectif est d'accélérer le processus tout en maintenant une validation humaine finale pour garantir la qualité académique.

Automatisation du traitement de résumés de conférences académiques par un workflow n8n Développer une chaîne de traitement automatisée permettant de transcrire le contenue, généré des résumées, d'extraire des citations ainsi que d'associé des mots-clés de vidéo de conférence académique pour faciliter leur indexation, leur valorisation documentaire et leur intégration dans Omeka S. L'objectif est d'accélérer le processus tout en maintenant une validation humaine finale pour garantir la qualité académique. Hoyte van Hoytema

Hoyte van Hoytema  Captures d'écran du film Her (2013)

Captures d'écran du film Her (2013)  The Fall of the Aztec Empire (1521) Image 3

The Fall of the Aztec Empire (1521) Image 3  The Fall of the Aztec Empire (1521) Image 2

The Fall of the Aztec Empire (1521) Image 2  The Fall of the Aztec Empire (1521) Image 1

The Fall of the Aztec Empire (1521) Image 1  Vladan Joler

Vladan Joler  JavaScript « JavaScript (JS) est un langage de programmation léger, interprété (ou compilé juste‑à‑temps), avec des fonctions de première classe; il est surtout connu comme langage de script des pages Web, mais est aussi utilisé hors navigateur, par exemple avec Node.js, Apache CouchDB ou Adobe Acrobat. » -Traduit par GPT-5 Source : https://developer.mozilla.org/en-US/docs/Web/JavaScript

JavaScript « JavaScript (JS) est un langage de programmation léger, interprété (ou compilé juste‑à‑temps), avec des fonctions de première classe; il est surtout connu comme langage de script des pages Web, mais est aussi utilisé hors navigateur, par exemple avec Node.js, Apache CouchDB ou Adobe Acrobat. » -Traduit par GPT-5 Source : https://developer.mozilla.org/en-US/docs/Web/JavaScript Jack Halberstam

Jack Halberstam  Terence Broad

Terence Broad  Anil Bawa-Cavia

Anil Bawa-Cavia